Em artigo publicado no periódico britânico Nature – e que já havia vazado para as redes sociais em setembro –, pesquisadores do Laboratório de Inteligência Artificial Quântica da Google e colaboradores afirmam ter atingindo a chamada supremacia quântica.

Supremacia quântica – termo cunhado pelo pesquisador norte-americano John Preskill, do Instituto de Tecnologia da Califórnia (EUA) – é a fase na qual computadores quânticos – isto é, processadores programáveis que usam lógica quântica – são capazes de resolver problemas matemáticos que não podem ser resolvidos com computadores clássicos, ou seja, esses que usamos diariamente.

Para atingir tal etapa, os autores do artigo construíram um protótipo de computador quântico e o usaram para resolver, em 200 segundos, um problema que, segundo estimativas dos próprios pesquisadores, custaria ao mais potente supercomputador da atualidade cerca de 10 milênios!

Esse resultado é um marco. Computadores quânticos, capazes de resolver problemas até então intratáveis, são agora realidade. A pesquisa básica feita, por décadas, por milhares de cientistas espalhados pelo mundo, está, neste momento, à beira de virar tecnologia.

Como diz frase atribuída a Marshall MacLuhan (1911-1980), teórico da comunicação canadense: “Nós moldamos nossas ferramentas, e, depois, elas nos moldam.” A forma como computadores quânticos vão nos moldar ainda é imprevisível. Seja como for, a mudança vai ser radical, e precisamos estar preparados.

Nos computadores de nosso cotidiano – ditos clássicos –, a informação é armazenada e processada em bits – a palavra bit vem da sigla em inglês para dígito binário ([bi]nary digi[t]). Um bit é uma variável numérica que pode assumir um de dois valores: 0 ou 1.

Na prática, um bit pode assumir várias formas. Em um transistor (componente eletrônico que é a base dos computadores clássicos), voltagens abaixo de 0,8 volt são usadas para representar bits com valor 0, enquanto aquelas acima de 2,2 volts definem o valor 1 – em tempo: voltagens entre 0,8 e 2,2 não são usadas, para evitar erros na determinação dos bits.

Como esses valores estão associados a diferentes voltagens macroscópicas – podemos medi-las com um voltímetro usual –, um bit assume ora o valor 0, ora o valor 1.

Mas, se para processar informação, usamos sistemas na escala quântica (partículas atômicas ou subatômicas), temos mais possibilidades. Uma das propriedades mais intrigantes de partículas quânticas é que elas podem existir naquilo que os físicos denominam superposição quântica. Por exemplo, em um dado instante, um elétron pode estar em uma superposição de dois pontos espaciais – ou seja, nem o elétron está em um ponto, nem no outro; ele não tem posição bem definida.

A versão quântica do bit, o chamado q-bit, pode, então, ser preparado em uma superposição dos valores 0 e 1. Quando nesse estado, o valor do q-bit não é bem definido. Ele apenas vai assumir o valor 0 ou 1, probabilisticamente, quando realizamos uma medição.

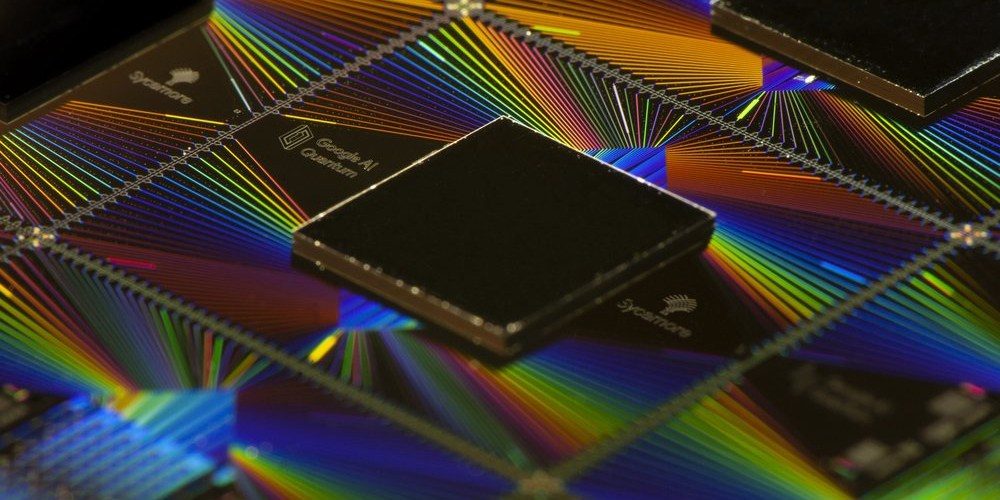

O experimento feito pela Google e colaboradores emprega q-bits feitos a partir de circuitos supercondutores. Um supercondutor é um tipo de metal que, quando resfriado a temperaturas baixíssimas (muito próximas do zero absoluto, ou seja, de 273 graus celsius negativos), conduz corrente elétrica sem dissipar energia. Nessas condições extremas, efeitos quânticos são possíveis, e podemos gerar as tais superposições dos valores 0 e 1.

Nesse arranjo experimental, a definição dos valores 0 e 1 depende do número de pares de elétrons em uma parte específica do circuito, chamada ilha supercondutora. Temos assim um q-bit supercondutor.

Computadores clássicos trabalham com um número imenso de bits. Por exemplo, em um processador Pentium Core i7, há mais de 500 milhões de transistores, cada um deles fazendo o papel de um bit. Computadores quânticos, no entanto, ainda estão longe de ter semelhante número de q-bits. O computador quântico da Google tem somente 53 deles. Mas o que pode parecer ínfimo quando comparado com os 500 milhões de bits em um processador clássico esconde uma capacidade computacional imensa.

O fenômeno de superposição quântica se manifesta de forma ainda mais surpreendente para sistemas de mais de um q-bit, originando o efeito quântico mais contraintuitivo: o emaranhamento. Emaranhamento é um tipo de correlação que pode existir entre sistemas quânticos mais forte que o possível entre sistemas clássicos. Por exemplo, quando dois q-bits estão emaranhados, se medirmos cada um deles individualmente, obteremos resultados aleatórios. Porém, se medirmos os dois q-bits conjuntamente, é possível obter resultados determinísticos (sem aleatoriedade). O estado individual de cada q-bit não está definido, mas o estado conjunto do par, sim. Esse curioso efeito não tem análogo clássico.

Da mesma forma, quando N q-bits estão emaranhados, o sistema total não é definido pela simples descrição de cada q-bit individualmente. Diferentemente do caso clássico, na arena quântica, em termos de informação, o todo é maior que soma das partes.

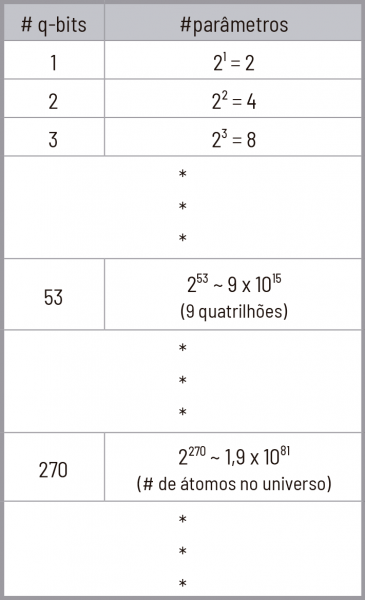

Mais ainda: para um computador clássico descrever um sistema de N q-bits emaranhados é necessário, em geral, especificar um número exponencial em N de parâmetros – valores numéricos que definem a configuração dos N q-bits. Para se ter uma ideia, para descrevermos classicamente um sistema composto por 53 q-bits, precisaríamos especificar da ordem de 253, cerca de 9 quatrilhões, de parâmetros. Na prática, isso representaria algo na casa de milhões de gigabytes, o que é intratável para os computadores de hoje.

Se quisermos ir um pouco além e descrever um sistema quântico com meros 270 q-bits, o número de parâmetros necessários seria maior do que o número de átomos no universo!

Conclusão: não existe – e nem nunca existirá – computador clássico que tenha semelhante poder computacional.

Foi justamente por perceber esse crescimento exponencial que, em 1981, o físico norte-americano Richard Feynman (1918-1988), Nobel de Física de 1965, sugeriu a ideia dos computadores quânticos. Como a estrutura deles já é baseada em q-bits, para descrever um sistema de 270 q-bits, são necessários exatamente… 270 q-bits. Simples e genial.

Um computador quântico não só descreve sistemas quânticos de forma eficiente. Como o computador quântico é capaz de lidar com sistemas muito mais complexos, podemos usá-lo também para resolver outros problemas matemáticos intratáveis para o computador clássico.

O exemplo mais famoso é a fatoração em números primos. Por exemplo, decompondo o número 15 em fatores primos, temos: 15 = 3 x 5 (3 e 5 são números primos). Mas, quanto maior o número a ser decomposto, mais difícil é achar seus fatores primos. Toda a criptografia na internet – como a que garante a privacidade de transações bancárias ou com cartões de crédito, por exemplo – depende dessa dificuldade.

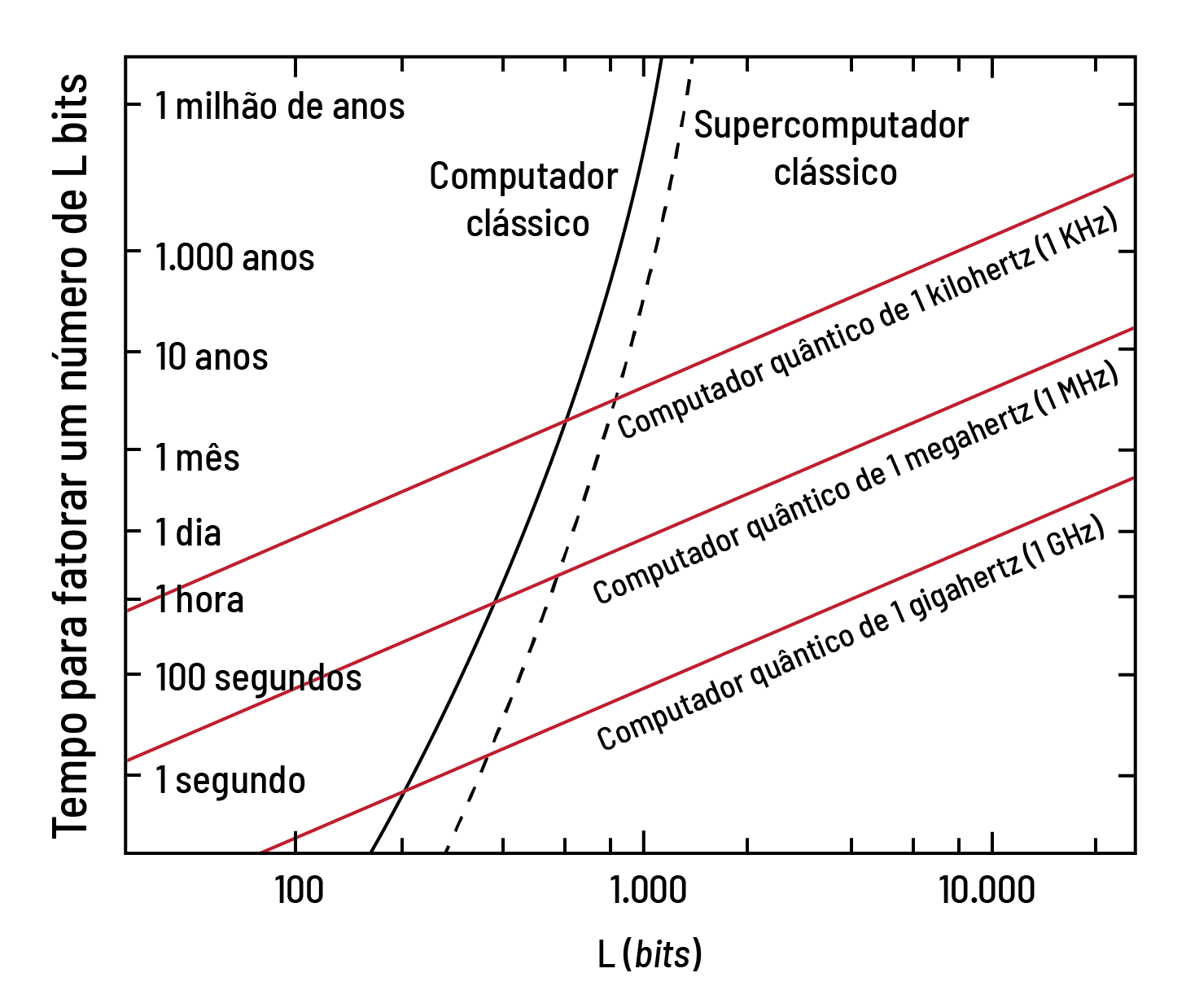

Porém, esse obstáculo existe somente para computadores clássicos. Para um computador quântico, essa tarefa é simples. Para colocarmos em perspectiva, achar os fatores primos de um número com 1 mil dígitos (binários) levaria cerca de 1 milhão de anos com um computador clássico, enquanto, em um computador quântico, precisaríamos de apenas algumas horas

Na era quântica que agora se inaugura, nossa privacidade não será a mesma: a segurança cibernética terá que se basear em técnicas criptográficas quânticas – nas quais até os canais de comunicação são quânticos – ou pós-quânticas – nas quais a criptografia é baseada em problemas matemáticos mais difíceis do que fatoração que até mesmo computadores quânticos não conseguem resolver rapidamente.

Mas nem todas as perspectivas da computação quântica são assustadoras. Na verdade, a grande maioria delas é altamente promissora. Com computadores quânticos, poderemos fazer melhores previsões do tempo, desenhar novas drogas, achar poços de petróleo mais facilmente, gerar e distribuir eletricidade mais eficientemente, projetar materiais mais leves e fortes, desenvolver carros autônomos mais confiáveis… A lista de benefícios é longa.

Em geral, todos os problemas que envolvam soluções complexas (sistemas enormes de equações, otimizações complicadas, buscas em bases de dados não ordenadas etc.) poderão ser enormemente beneficiados com o advento de computadores quânticos de grande escala.

A maior dificuldade para a construção de computadores quânticos de grande escala é a fragilidade das superposições e do emaranhamento. Por exemplo, os q-bits de circuitos supercondutores estão constantemente sujeitos a imperfeições físicas e ao calor do ambiente (ruído térmico). Isso, rapidamente, destrói esses dois fenômenos quânticos, fazendo com que q-bits se tornem bits clássicos, acabando, assim, com toda vantagem computacional quântica.

Para podermos rodar algoritmos quânticos complexos, precisamos de técnicas de correção quântica de erros, as quais precisam de q-bits extras para a correção. Portanto, levando-se em conta esses q-bits extras, um computador quântico capaz de fatorar números maiores que aqueles fatorados por computadores clássicos atuais precisará de dezenas de milhares de q-bits. Ainda estamos longe desse cenário.

Neste momento – e, talvez, pelos próximos cinco ou 10 anos –, teremos computadores quânticos com poucas centenas de q-bits, com taxas de erro relativamente altas e sem correção de erros. Esse é o paradigma NISQ, sigla, em inglês, para tecnologias quânticas ruidosas e de escala intermediária ([n]oisy [i]ntermediate [s]cale [q]uantum), no qual os impactos para a sociedade devem ser ainda tímidos, embora promissores, especialmente para as áreas de química quântica, otimizações combinatórias e aprendizado de máquina, com aplicações tecnológicas em setores industriais, comerciais e financeiros.

O experimento da Google e colaboradores se encaixa nesse paradigma NISQ. De forma simplificada, os pesquisadores realizaram – com a ajuda de um chip quântico programável de 53 q-bits batizado Sycamore – operações quânticas complexas, obtendo, ao final, listas de zeros e uns vindas da medição dos q-bits. Ou seja, o objetivo do experimento foi o de gerar listas de zeros e uns que aparecem com probabilidades específicas determinadas pelo sistema emaranhado dos 53 q-bits ao final de cada computação.

Devido à complexidade do estado dos 53 q-bits ao final da computação quântica realizada, um computador clássico não consegue gerar listas de zeros e uns com a mesma probabilidade que o computador quântico. Estima-se que reproduzir os resultados das medidas realizadas pelo chip quântico da Google em meros 200 segundos levaria, para o supercomputador clássico Summit (o mais potente do mundo), da IBM, 10 milênios!

Apesar de estabelecer a tal supremacia quântica, essa demonstração de força não tem aplicação imediata. E o resultado não foi consensual na comunidade de especialistas: logo após a publicação do artigo da Google e colaboradores, pesquisadores da empresa IBM – que também desenvolve chips quânticos – afirmaram que, pelas estimativas deles, o tempo para reproduzir os resultados obtidos com o chip Sycamore seria de dias e não milênios.

Seja como for, o resultado da Google e colaboradores é a pedra fundamental da corrida que levará ao desenvolvimento de computadores NISQ realmente úteis.

Embora o chip Sycamore ainda diste muito de um computador quântico em todo o seu esplendor, uma coisa é clara: o Brasil (e, de fato, toda a América Latina) já ficou para trás na corrida pelo chip quântico. É praticamente impossível para empreendimentos brasileiros concorrerem contra colossos como Google, IBM, Intel, Microsoft ou Alibaba no desenvolvimento de processadores quânticos.

Mais: além do setor privado, o investimento público em tecnologias quânticas no hemisfério Norte é muitíssimo superior ao destas latitudes. O governo dos Estados Unidos destinará US$ 1,2 bilhão (cerca de R$ 5 bilhões) ao segmento nos próximos cinco anos; a União Europeia, 1 bilhão de euros (cerca de R$ 4,5 bilhões) em dez anos; e a China construirá, em Hefei, um centro nacional de tecnologias quânticas de 37 hectares, com um investimento total da ordem de US$ 10 bilhões.

Em contraste, no Brasil, o maior investimento na área é o Instituto Nacional de Ciência e Tecnologia de Informação Quântica, lançado em 2017, com financiamento federal e estadual (RJ). O projeto consiste em um investimento total de R$ 7 milhões por cinco anos (2017-2021), a serem divididos entre 24 grupos de pesquisa espalhados pelo país.

Há, porém, um nicho no qual o Brasil ainda pode entrar no páreo: a nascente indústria de programação quântica (software quântico). Estudo da consultoria BCG estima que o mercado mundial de computação quântica alcance US$ 50 bilhões até 2030. Refletindo isso, está avançando fortemente o investimento em pequenas empresas de alta tecnologia (startups) dedicadas a desenvolver algoritmos e serviços baseados em computadores (hardware) quânticos disponíveis ‘na nuvem’.

Em 2017 e no ano passado, essas companhias receberam pelo menos US$ 450 milhões em investimentos privados – mais do que quatro vezes mais que os US$ 104 milhões dos dois anos anteriores. Nenhuma dessas startups é sul-americana, e, por enquanto, nenhuma empresa brasileira parece planejar seriamente usar a computação quântica.

Mas a nova tecnologia será, mesmo na fase NISQ, diretamente útil para múltiplas empresas brasileiras. Suas aplicações abrangerão setores de alta tecnologia e de big-data (inteligência artificial, redes neurais etc.); da indústria pesada (otimização de logística, desenho industrial, novos polímeros para aviões etc.); químico e farmacêutico (simulação de proteínas, fertilizantes artificiais para a agricultura, bioinformática, genômica etc.); energético (exploração petrolífera, desenho de redes elétricas, células solares mais eficientes, predições meteorológicas e oceanográficas etc.); e financeiro (otimização de portfólios, simulações de mercado etc.), entre outros.

A era da computação quântica não será uma revolução só para empresas do Norte. Mas, se o Brasil não desenvolver um ecossistema de software quântico nacional, vai passar a ser não só um importador de hardware quântico, mas também de todos os serviços associados – possivelmente, pouco adaptados às necessidades locais e, portanto, demandando custosas transferências de tecnologia.

As universidades e centros de pesquisa brasileiros contam com especialistas altamente qualificados para atuar na criação de algoritmos quânticos especializados para os problemas locais. Portanto, o país não precisa – nem pode – ficar para trás nesse novo cenário, que não é só científico e tecnológico, mas também econômico e geopolítico. Para isso, além de aumentar significativamente o investimento público no setor, é necessário que os grandes industriais e investidores de risco brasileiros entrem, o quanto antes, na era quântica.

Pelo lado acadêmico, nós, cientistas da computação quântica no Brasil, já estamos prontos para o desafio.

Fernando de Melo

Centro Brasileiro de Pesquisas Físicas (RJ)

Leandro Aolita

Instituto de Física,

Universidade Federal do Rio de Janeiro

Dando sequência à série de colunas sobre a origem da vida, conheça as primeiras explicações científicas para o surgimento dos seres vivos, a começar pela teoria da geração espontânea a partir de matéria inanimada, que influenciou cientistas por mais de 2 mil anos.

Com uma vitoriosa carreira acadêmica dedicada a dar voz aos que foram silenciados no passado, Hebe Mattos faz um retrospecto das diferentes fases de seu trabalho, que extrapola os muros da universidade com a produção de livros e filmes historiográficos.

Muitas tecnologias capazes de tornar objetos invisíveis já estão sendo testadas, mas ainda há alguns desafios a serem vencidos para que esse poder tão comum nos quadrinhos e na ficção científica seja usado no mundo real.

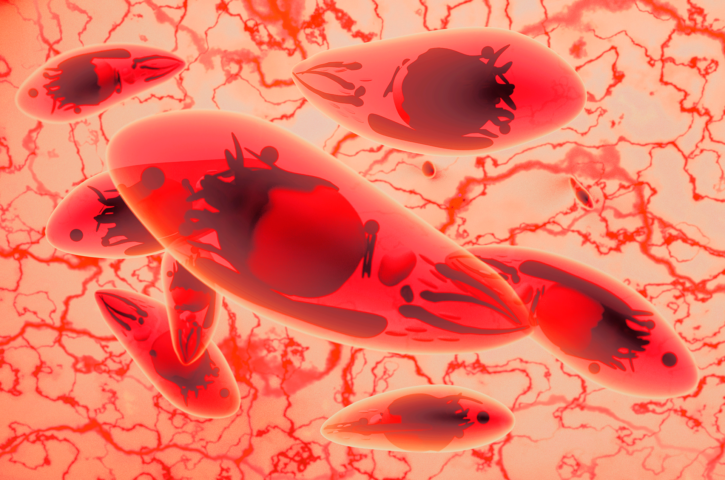

Doença causada pelo parasita Toxoplasma gondii atinge milhões de brasileiros, com consequências graves para a saúde pública. Pesquisadores estão propondo alternativas de tratamento para acelerar o processo de descoberta de novos medicamentos e assim beneficiar os pacientes.

A exploração do espaço voltou a ganhar momento, com a entrada em cena não só de novas agências espaciais, mas também de empresas que exploram comercialmente essa atividade. A tensão ideológica que marcou esse campo foi substituída pela cooperação

O mercado de sementes modificadas e dependentes de pesticidas tóxicos à saúde e ao ambiente está cada vez mais concentrado em algumas poucas megaempresas. É essencial visibilizar as formas de produção por trás do que comemos para alcançar alternativas saudáveis e justas

Há 50 anos, o lançamento do satélite Landsat-1 transformou nosso olhar sobre a superfície terrestre. Hoje, as técnicas de machine learning e deep learning promovem uma nova revolução, desta vez na “visão” dos computadores e no sensoriamento remoto do planeta

A física quântica, que lida com o microuniverso atômico e subatômico, promete revolucionar as comunicações. Pergunta procedente neste Ano Internacional da Ciência e das Tecnologias Quânticas: o Brasil será um agente ativo nessa nova era tecnológica?

Este é o Ano Internacional da Ciência e das Tecnologias Quânticas. Poder soar como tema para poucos. Mas os fenômenos quânticos e suas aplicações permeiam nosso cotidiano, trazendo bem-estar à sociedade. Mais: nos ensinam o valor da pesquisa em ciência básica.

Nascido na forma de um experimento mental, o emaranhamento quântico levou décadas até ser comprovado. Hoje, ao comemorarmos o Ano Internacional da Ciência e das Tecnologias Quânticas, esse fenômeno define a essência da física quântica

Os fenômenos do mundo macroscópico, em que vivemos, são bem diferentes daqueles que ocorrem com átomos e moléculas. Há uma sutil (e misteriosa) fronteira entre esses dois mundos, apresentada neste artigo, que comemora o Ano Internacional da Ciência e das Tecnologias Quânticas

Imagine o mundo atual sem o bronze, o latão ou o aço. Quase impossível. As ligas metálicas fazem parte da humanidade desde a Antiguidade. Hoje, o desenvolvimento dessas misturas de elementos químicos conta com ajuda importante: computação avançada e inteligência artificial

Em 1925, o físico Albert Einstein, um dos maiores cientistas de todos os tempos, desembarcava no porto do Rio de Janeiro. A viagem – que incluiu Argentina e Uruguai – deixou um legado importante: evidenciou a importância da pesquisa básica no meio acadêmico brasileiro

| Cookie | Duração | Descrição |

|---|---|---|

| cookielawinfo-checkbox-analytics | 11 months | This cookie is set by GDPR Cookie Consent plugin. The cookie is used to store the user consent for the cookies in the category "Analytics". |

| cookielawinfo-checkbox-functional | 11 months | The cookie is set by GDPR cookie consent to record the user consent for the cookies in the category "Functional". |

| cookielawinfo-checkbox-necessary | 11 months | This cookie is set by GDPR Cookie Consent plugin. The cookies is used to store the user consent for the cookies in the category "Necessary". |

| cookielawinfo-checkbox-others | 11 months | This cookie is set by GDPR Cookie Consent plugin. The cookie is used to store the user consent for the cookies in the category "Other. |

| cookielawinfo-checkbox-performance | 11 months | This cookie is set by GDPR Cookie Consent plugin. The cookie is used to store the user consent for the cookies in the category "Performance". |

| viewed_cookie_policy | 11 months | The cookie is set by the GDPR Cookie Consent plugin and is used to store whether or not user has consented to the use of cookies. It does not store any personal data. |