Bastaria uma linha do currículo do físico teórico brasileiro Fernando Brandão para resumir o quanto ele alcançou em sua carreira: é o primeiro brasileiro a assumir uma cátedra no prestigioso Caltech (Instituto de Tecnologia da Califórnia). Mas há outro fato que dá contornos ainda mais surpreendentes a esse feito profissional: ele tem apenas 33 anos.

Formado pela Universidade Federal de Minas Gerais e com doutorado pelo Imperial College (Reino Unido), Brandão – agora, ocupante da cátedra Bren de Física Teórica, do Caltech – já havia passado por instituições igualmente renomadas: o University College London, a escola Politécnica de Zurique (Suíça) e o centro de pesquisas da empresa Microsoft.

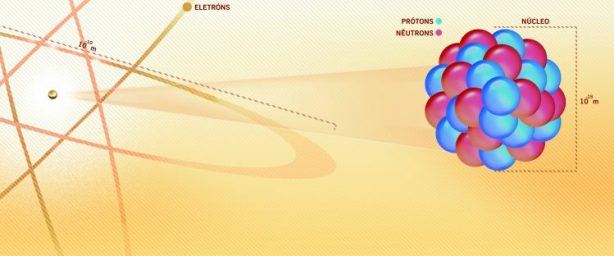

Ganhador de vários prêmios e distinções, Brandão trabalha com informação quântica, área que, entre outros temas, lida com a construção de computadores hipervelozes e com a transmissão 100% segura de dados. Sua especialidade é o emaranhamento, considerado o fenômeno mais intrigante (e esquisito) da natureza, que permite que dois ou mais objetos – do mundo subatômico – permaneçam ‘conectados’, mesmo que espacialmente separados por milhões de anos-luz.

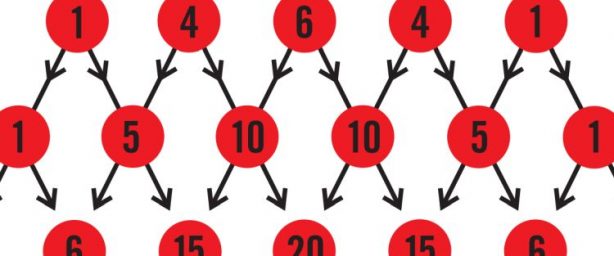

Nos computadores clássicos (comuns), um bit (ou unidade) de informação só pode assumir os valores um ou zero. Nos computadores quânticos, os bits quânticos (ou q-bits) podem ser um e zero simultaneamente, o que confere a essas máquinas uma velocidade extremamente alta de processamento de informação.

Nesta entrevista, Brandão fala sobre essa fronteira do conhecimento, a evolução da área e os desafios ainda por vencer.

No início deste século, havia esperança de que, por volta de 2020, já teríamos computadores quânticos operando comercialmente. Mas, parece que ainda estamos longe de ter máquinas assim, que poderiam resolver, em minutos, problemas que levariam bilhões de anos para um supercomputador convencional. O que aconteceu? Excesso de otimismo à época ou obstáculos tecnológicos até agora intransponíveis?

O otimismo inicial de alguns pesquisadores parece ter sido excessivo. Nos últimos anos, temos visto um avanço encorajador na construção de um computador quântico, e não acho que haja motivo para duvidarmos de que, um dia, ele será realidade. Mas, desde o começo, era claro que se tratava de um projeto de muitas décadas de desenvolvimento. Na verdade, um computador quântico é mais do que uma nova tecnologia. Ele é o desenvolvimento de uma fronteira da física até então não explorada: sistemas quânticos altamente complexos. Estamos mais acostumados a experimentos que demoram muito tempo para mostrar resultados em outras fronteiras da física. Por exemplo, na fronteira da física de energias muito altas, temos o acelerador de partículas do Cern [Centro Europeu de Pesquisas Nucleares, na Suíça], que demorou décadas até a detecção da partícula bóson de Higgs, em 2012. Já na fronteira da física de grandes massas, temos o LIGO [sigla, em inglês, para Observatório de Ondas Gravitacionais por Interferometria a Laser], cuja concepção ocorreu há mais de 30 anos e só agora detectou a primeira onda gravitacional. Nos dois casos, a espera valeu a pena. Acho que valerá também para a computação quântica! E, como um bônus, uma vez que tivermos um computador quântico, não só entenderemos melhor uma parte importante da física, mas também teremos uma tecnologia revolucionária.

Há alguns anos, a empresa canadense D-wave anunciou que havia construído o primeiro computador quântico. Mais recentemente, apresentou computadores com mais de 1 mil q-bits (bits quânticos, a unidade de informação quântica), bem como parcerias com universidades, empresas e laboratórios nacionais. Em termos simples, as máquinas da D-wave são realmente computadores quânticos como os entendemos? A tecnologia embutida nelas é promissora?

A tecnologia usada pela D-wave é baseada nos chamados q-bits supercondutores, a qual tem sido explorada ao redor do mundo na última década. Na visão de muitos pesquisadores da área, essa é a plataforma mais promissora para um computador quântico. O maior obstáculo na construção de um computador quântico é reduzir o ruído [a interferência do ambiente] nos q-bits a um nível no qual protocolos [procedimentos] quânticos de correção de erro possam ser utilizados. Como é muito difícil isolar sistemas quânticos do resto do mundo – o que nos leva a não observarmos efeitos quânticos no dia a dia –, essa redução do ruído não é uma tarefa nada fácil. Desse modo, ainda só temos experimentos com uma taxa de erros suficientemente baixa envolvendo alguns poucos q-bits. A D-wave resolveu tomar um caminho alternativo e não se preocupar com a taxa de erro, o que permitiu aumentar o número de q-bits rapidamente. O preço disso é que não se trata de um computador quântico universal – ou seja, que pode fatorar números muito mais rapidamente do que computadores tradicionais –, mas, sim, de um tipo de computador analógico especializado em problemas particulares. Pode ser que, um dia, esse tipo de computador quântico rudimentar se mostre útil, mas, por enquanto, ele ainda não mostrou nenhuma vantagem sobre os computadores tradicionais.

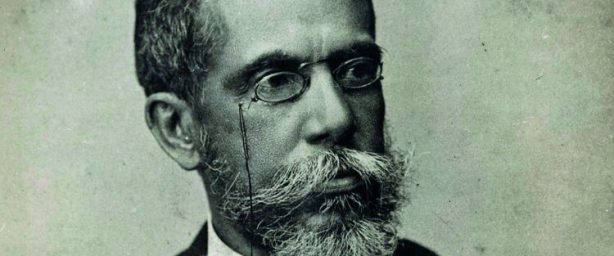

O físico teórico brasileiro Fernando Brandão.

(foto: Hohe Auflösung)

A IBM disponibilizou, para uso público, por meio de uma conexão on-line, um computador quântico com modestos cinco q-bits. Essa máquina é realmente quântica? O que ela é capaz de fazer?

Sim, é realmente quântica. Como se trata de apenas cinco q-bits, esse protótipo da IBM não pode fazer nenhuma computação interessante. Ele é mais uma prova de conceito para que o grande público possa participar do desenvolvimento da área.

O maior problema para a construção de computadores quânticos é o da ‘escalabilidade’. Ou seja, o aumento no número de q-bits até a casa dos milhares. Em que tecnologia o senhor hoje apostaria como a mais promissora para superar esse obstáculo?

Acredito que q-bits supercondutores sejam a plataforma mais promissora, por serem baseados em tecnologia da física do estado sólido que foi tão útil no desenvolvimento de computadores clássicos, baseados em transistores. Mas existem outras plataformas interessantes e estamos ainda no começo do jogo para colocarmos toda a energia em uma plataforma só. Por exemplo, os chamados q-bits topológicos também parecem ser um bom candidato. Esse tipo de q-bit pode ser representado por uma classe especial de partículas, denominadas férmions de Majorana, encontradas nas extremidades de fios muito finos, os nanofios, cuja espessura é da ordem de bilionésimos de metro. Um dos grandes insights da teoria da informação quântica nos últimos 20 anos foi o de que um computador quântico é muito mais próximo de um computador digital do que de um analógico. Isso quer dizer que é possível operar o sistema de uma maneira tolerante a erros. Assim, a não ser que estejamos errados sobre os fundamentos da mecânica quântica [teoria que lida com os fenômenos atômicos e subatômicos], e as regras que conhecemos hoje não se apliquem a um grande número de sistemas quânticos (na ordem de bilhões de q-bits) interagindo fortemente, acredito que, sim, teremos um computador quântico universal. A grande dúvida é quando isso acontecerá. Pode levar décadas, mas pode ocorrer muito mais rapidamente, como aconteceu no desenvolvimento dos computadores convencionais, depois que o transistor foi inventado.

Um dos desdobramentos práticos da área de informação quântica é a chamada criptografia quântica, ou seja, um modo inviolável de enviar e receber mensagens, de fazer compras seguras on-line etc. Quão longe estamos de uma internet quântica global, na qual hackers seriam coisa do passado?

Ao contrário da computação quântica, já existem empresas vendendo dispositivos para a troca de chave secreta baseada na mecânica quântica. Ou seja, sistemas quânticos de criptografia privada já são uma tecnologia atual. O sistema de criptografia mais usado hoje é o RSA. Sua segurança é baseada na conjectura de que fatorar números muito grandes requer muito tempo. Portanto, alguém conseguiria quebrar o RSA apenas com a capacidade de fatorar números muito rapidamente. Até onde sabemos, não existe nenhum algoritmo eficiente para fatorar números, o que torna seguro o RSA. Mas claro que vemos ataques de hackers frequentemente. O que eles exploram são falhas na implementação do RSA, o que leva a fragilidades do sistema que podem ser exploradas. O mesmo é verdade no caso da criptografia quântica. Embora, em princípio, o protocolo seja impenetrável se implementado corretamente, na prática todo sistema terá fragilidades. Um dos maiores tópicos de estudo na criptografia quântica atual é a criação de protocolos que minimizam essas possíveis fragilidades. Dado que já há sistemas criptográficos quânticos, devemos nos perguntar por que eles não são usados em grande escala. A resposta é que o RSA funciona muito bem. Entretanto, um dos algoritmos quânticos mais importantes já descobertos é o algoritmo de Shor [referência ao matemático norte-americano Peter Shor], para a fatoração de números em tempo cúbico, ou seja, em um tempo muito mais curto que aquele que seria necessário para um computador convencional. Assim, um computador quântico quebraria facilmente o RSA. É um pouco irônico que um computador quântico pareça ser o que falta para abrir o mercado para a criptografia quântica!

Em 1961, o físico Rolf Landauer (1927-1999), então na IBM, mostrou que, para apagar um bit de informação, é necessário um mínimo de energia. Com esse princípio – denominado princípio de Landauer –, ele estabeleceu uma ligação entre a área de teoria da computação e a teoria do calor (termodinâmica). Hoje, fala-se muito em termodinâmica quântica. O que é essa nova área? Podemos esperar algo de prático dela?

A termodinâmica é provavelmente a área da física com o maior grau de alcance. Ela é relevante na descrição desde máquinas a vapor até buracos negros. [O físico de origem alemã Albert] Einstein [1879-1955] disse certa vez: “a termodinâmica é a única teoria física cujo conteúdo eu estou convencido de que não será derrubado”. Mas, quando se estuda termodinâmica, pela primeira vez, ela parece ser uma teoria ad hoc [ou seja, dotada de hipóteses ‘artificiais’], baseada em observações empíricas. Com o desenvolvimento da mecânica estatística pelo [físico teórico austríaco Ludwig] Boltzmann [1944-1906], [pelo norte-americano Josiah] Gibbs [1839-1903] e por muitos outros, no final do século 19, ficou claro que a termodinâmica é intimamente conectada com a informação que um observador tem sobre um sistema físico. A descoberta de Landauer de que ‘esquecer’ [apagar a informação] custa trabalho [ou seja, gasta-se energia] – portanto, não fazendo sentido falar do conceito de informação sem um meio físico – é a culminação dessa longa linha de investigação.

Uma das limitações da teoria é que ela só descreve sistemas físicos grandes, aqueles em que as leis da mecânica estatística se aplicam. Motivado por novas ideias da informação quântica, recentemente se tornou um importante tópico de estudo a extensão da termodinâmica para sistemas muito pequenos, em nível quântico. Uma surpresa foi que muitos aspectos da teoria ainda se aplicam, mas com diferenças interessantes. Por exemplo, com colegas da Universidade de Gdansk [Polônia] e do University College London, eu descobri que a segunda lei da termodinâmica – que estipula que a entropia (ou desordem) de um sistema isolado do ambiente sempre aumenta – ainda é, de certa forma, válida, mas sua forma matemática é modificada, e a entropia única da termo- dinâmica tem que ser substituída por uma família de entropias válidas para sistemas de poucas partículas (PNAS, 17/03/15). Pesquisadores do mundo todo estão trabalhando intensamente no momento para elucidar outros aspectos da termodinâmica quântica.

O senhor é especialista no fenômeno considerado ‘mais esquisito’ da natureza: o emaranhamento. Em termos simples, esse fenômeno diz que, se alterarmos algo aqui, alteramos instantaneamente algo ali – mesmo que essas duas partes estejam separadas por bilhões de quilômetros. No emaranhamento, não há transmissão de massa, de energia, nem mesmo de informação – pois isso violaria a teoria da relatividade, que diz que nada pode se comunicar com velocidade superior à da luz. O que é, então, o emaranhamento? Como é possível que ele ocorra instantaneamente?

O emaranhamento é um tipo especial de correlação entre sistemas físicos que não tem um análogo na física clássica [ou seja, em nosso cotidiano]. Todos nós estamos familiarizados com o conceito de correlação. Por exemplo, a cotação das ações da Petrobras é correlacionada com a cotação do barril de petróleo. Sistemas quânticos podem se correlacionar de uma maneira ainda mais forte, e esse tipo de correlação é o que chamamos de emaranhamento. Como se trata apenas de correlações, não existe, de fato, transmissão de informação, e o fenômeno é compatível com a teoria da relatividade. Mas o que distingue o emaranhamento das correlações a que estamos acostumados no dia a dia? Há muitas respostas, uma particularmente interessante é que o emaranhamento é um tipo de correlação que não pode ser livremente compartilhada. Por exemplo, o preço de um número arbitrário de ações de empresas diferentes pode ser perfeitamente correlacionado. Mas o mesmo não ocorre com o emaranhamento. Quanto mais um sistema está emaranhado com outro, menos ele pode estar emaranhado com qualquer outro sistema. Essa propriedade central das correlações quânticas é chamada ‘monogamia do emaranhamento’ – e, a propósito, essa é a ideia primordial por trás da criptografia quântica. Se dois sistemas estão maximamente emaranhados, eles estão perfeitamente correlacionados e automaticamente descorrelacionados do resto do universo. Assim, essas correlações, que não são conhecidas por mais ninguém, podem ser usadas para a obtenção de uma chave secreta para a criptografia quântica. O emaranhamento também é muito importante na computação quântica. De fato, ele está por trás da dificuldade de simular sistemas quânticos em computadores clássicos, o que foi a motivação inicial para se construir um computador quântico. Na visão moderna da informação quântica, o emaranhamento é visto como um novo recurso físico, que pode ser usado no processamento de informação. Boa parte da minha pesquisa é exatamente desenvolver a teoria do emaranhamento como um recurso físico.

O senhor poderia ter ficado no Brasil. Mas optou por fazer carreira no exterior. Por quê?

Para uma boa formação científica, é crucial o contato com muitos pesquisadores que tenham acumulado competências e experiências diversas. Assim, é quase imprescindível trabalhar em vários lugares, até se estabelecer como um pesquisador independente. Como gosto também de conhecer novas culturas, isso me levou a viajar bastante, até me estabelecer, agora, no Caltech nos EUA. Seria ótimo se, um dia, eu pudesse trabalhar no Brasil com as mesmas condições que tenho no Caltech atualmente, mas, apesar de alguns avanços recentes no fomento e organização da ciência brasileira, isso, infelizmente, ainda parece ser um sonho distante.

O senhor trabalhou cerca de dois anos na gigante Microsoft como pesquisador e, agora, está de volta à academia, tornando-se o primeiro brasileiro a assumir uma cátedra no Caltech. É muito diferente a forma de fazer pesquisa no setor privado e na universidade?

A Microsoft é uma das poucas empresas do mundo que ainda financiam pesquisa fundamental, no longo prazo, em áreas promissoras para a missão da companhia. Nesse sentido, meu trabalho lá foi bastante similar àquele no meio acadêmico. Mas sempre há diferenças. Por exemplo, no setor privado, temos a necessidade maior de justificar a relevância do tópico de pesquisa. Apesar de nem sempre isso ser benéfico para o desenvolvimento científico, aprendi, trabalhando na Microsoft, que, na dose certa, é importante não perder o foco do motivo de se realizar determinado projeto e de como ele se conecta com objetivos maiores da área de estudo. Como exemplo, cito um dos projetos que desenvolvi na Microsoft: um novo algoritmo quântico para acelerar, em relação à computação clássica, a resolução de certos tipos de problemas de otimização, chamados programas semidefinidos. Se eu não estivesse trabalhando na Microsoft, não sei se teria me dedicado a esse tópico. O foco da empresa em aplicações de um futuro computador quântico me levou a pensar mais em algoritmos quânticos. Foi uma experiência muito interessante, e pretendo continuar a tentar desenvolver novos algoritmos quânticos em minha pesquisa futura.

Cássio Leite Vieira

Ciência Hoje/ RJ