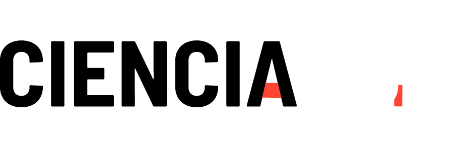

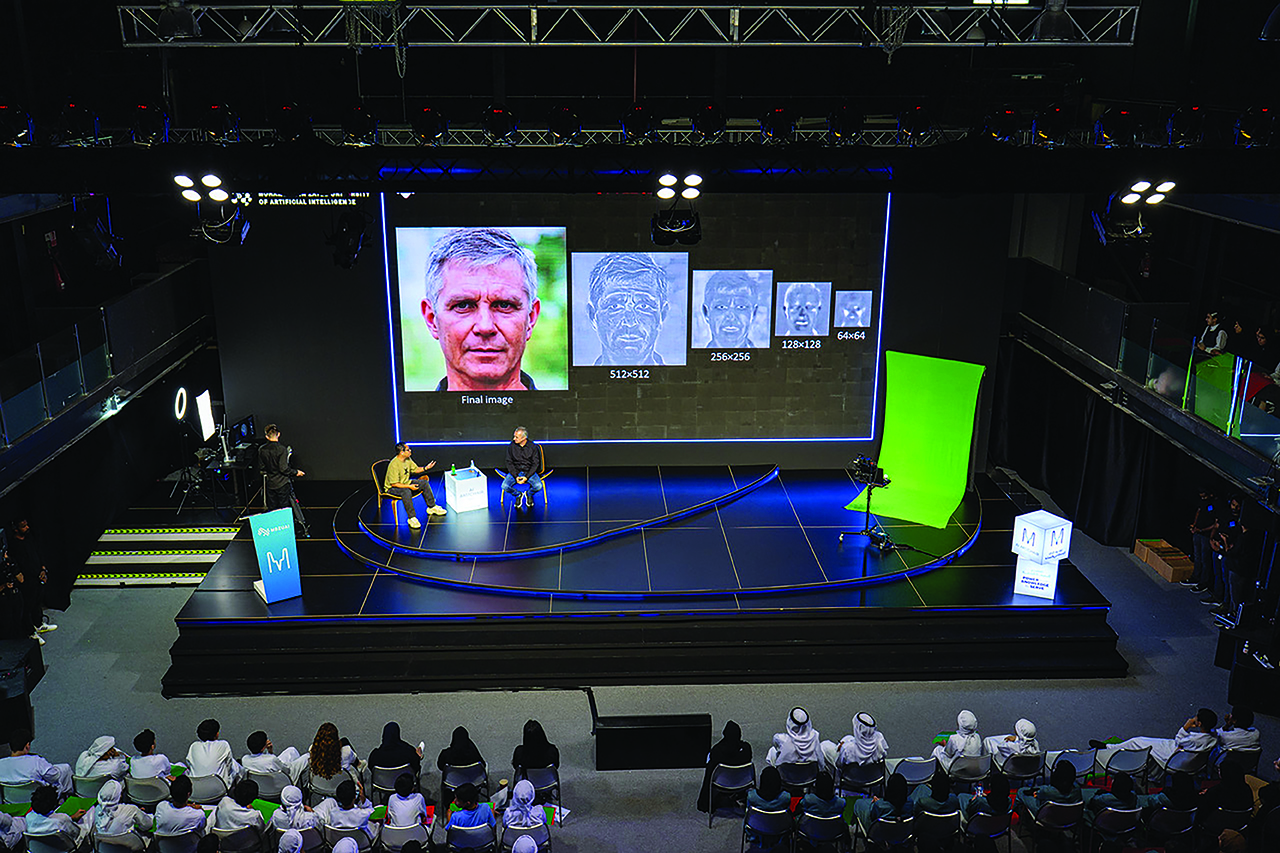

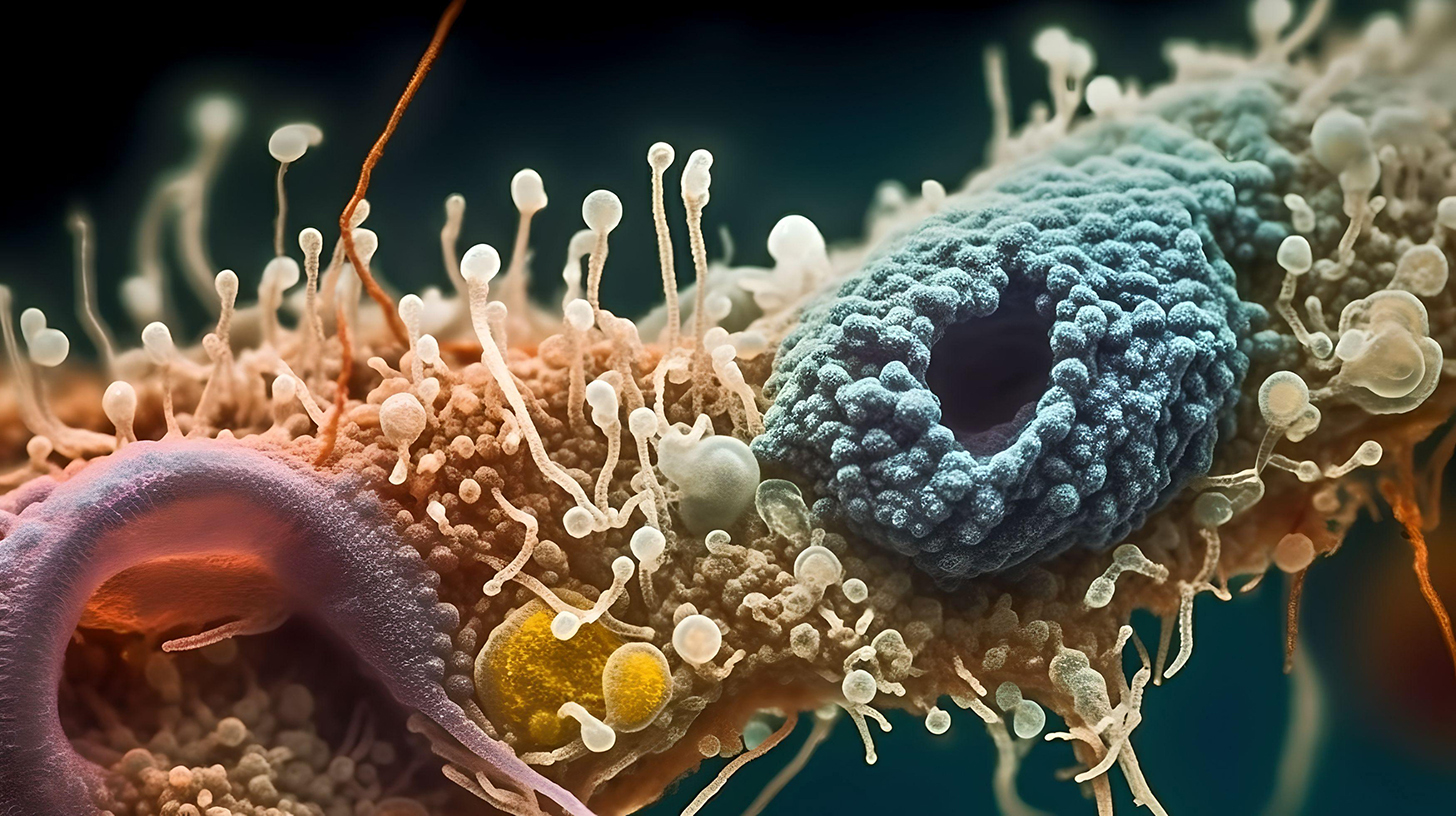

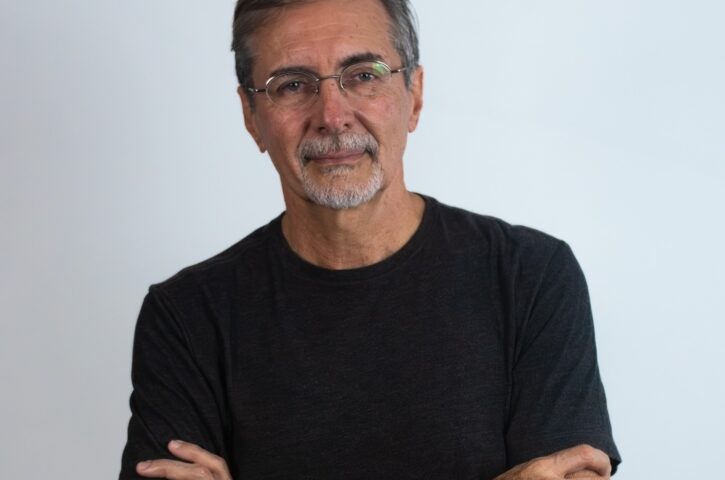

Um dos principais nomes da IA generativa, o cientista da computação Hao Li vislumbra um futuro em que a tecnologia será capaz de criar humanos digitais, reconstituir o passado e construir metrópoles em tempo real. Mas ele reconhece dilemas éticos: ‘O importante é as pessoas saberem o que é possível’